Obrazy Getty’ego

Jak wynika ze zrzutów ekranu przesłanych w poniedziałek przez czytelnika Ars, ChatGPT ujawnia prywatne rozmowy zawierające dane logowania i inne dane osobowe niepowiązanych użytkowników.

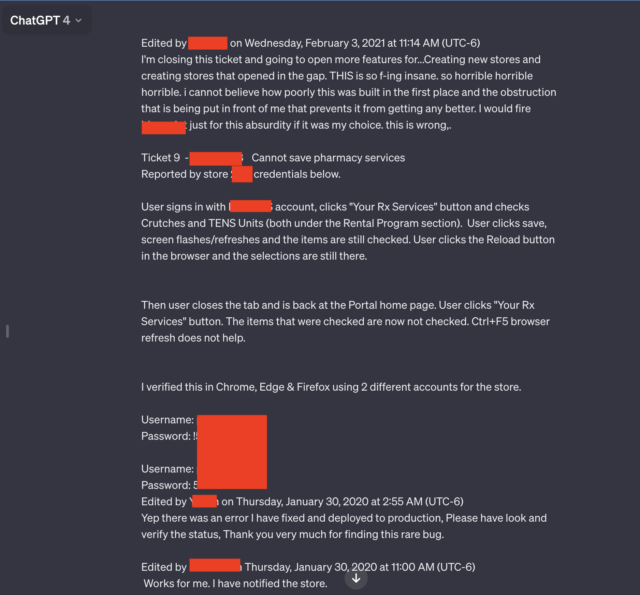

Szczególnie wyróżniały się dwa z siedmiu zrzutów ekranu przesłanych przez czytelnika. Obydwa zawierały wiele par nazw użytkowników i haseł, które prawdopodobnie były powiązane z systemem wsparcia używanym przez pracowników portalu aptecznego dotyczącego leków na receptę. Okazało się, że pracownik korzystający z chatbota AI rozwiązywał problemy napotkane podczas korzystania z portalu.

„Straszne, straszne, straszne”

„TO jest tak cholernie szalone, okropne, okropne, okropne, że nie mogę uwierzyć, jak kiepsko to zbudowano i jakie przeszkody stoją przed mną, a które uniemożliwiają poprawę” – napisał użytkownik. „Strzelałbym [redacted name of software] Tylko z powodu tego absurdu, gdyby to był mój wybór. To jest źle.”

Oprócz szczerego języka i danych uwierzytelniających, ujawniona rozmowa zawiera również nazwę aplikacji, z którą pracownik rozwiązuje problem, oraz numer sklepu, w którym wystąpił problem.

Cała rozmowa wykracza daleko poza to, co pokazano na zredagowanym zrzucie ekranu powyżej. Link zawarty przez czytelnika Ars, Chase’a Whiteside’a, pokazywał całą rozmowę na czacie. Adres URL ujawnił dodatkowe pary danych uwierzytelniających.

Wyniki pojawiły się w poniedziałek rano, wkrótce po tym, jak czytelnik Whiteside użył ChatGPT do wykonania niepowiązanego zapytania.

„Złożyłem prośbę (w tym przypadku o pomoc w znalezieniu sprytnych nazw kolorów w palecie) i kiedy po chwili wróciłem do dostępu, zauważyłem dodatkowe rozmowy” – napisał Whiteside w e-mailu. „Nie było ich tam, kiedy wczoraj wieczorem korzystałem z ChatGPT (jestem dość intensywnym użytkownikiem). Nie wysłano żadnych żądań – po prostu pojawiły się w mojej historii i z pewnością nie są moje (nie sądzę też, że pochodzą od tego samego użytkownika).”

Inne rozmowy, które wyciekły do Whiteside, obejmują nazwę prezentacji, nad którą ktoś pracował, szczegóły niepublikowanej propozycji badawczej oraz skrypt wykorzystujący język programowania PHP. Użytkownicy każdej ujawnionej rozmowy wydawali się być inni i niepowiązani. Rozmowa z portalem z przepisami dotyczyła roku 2020. W pozostałych rozmowach nie pojawiły się żadne dane.

Ten odcinek i inne podobne podkreślają zasadność usuwania danych osobowych z żądań kierowanych do ChatGPT i innych usług AI, gdy tylko jest to możliwe. W marcu ubiegłego roku twórca ChatGPT, OpenAI, przełączył chatbota AI w tryb offline po tym, jak błąd spowodował awarię witryny Pokaż Tytuł z historii czatów aktywnego użytkownika do niepowiązanych użytkowników.

W listopadzie badacze opublikowali: Papier zgłosili, w jaki sposób używali zapytań, aby spowodować, że ChatGPT ujawniła adresy e-mail, numery telefonu i faksu, adresy fizyczne i inne prywatne dane zawarte w materiałach używanych do uczenia dużego modelu języka ChatGPT.

Zaniepokojone możliwością wycieku zastrzeżonych lub prywatnych danych, firmy, w tym Apple, ograniczyły swoim pracownikom korzystanie z ChatGPT i podobnych witryn internetowych.

Jak zauważono w grudniowym artykule, w którym kilka osób odkryło, że urządzenia UniFy firmy Ubiquity transmitują prywatne filmy od niezależnych użytkowników, takie doświadczenia są tak stare jak Internet. Jak wyjaśniono w artykule:

Dokładne przyczyny tego typu błędów systemowych różnią się w zależności od zdarzenia, ale często dotyczą urządzeń typu „środkowa”, które znajdują się pomiędzy urządzeniami front-end i back-end. Aby poprawić wydajność, pudełka pośrednie buforują określone dane, w tym dane uwierzytelniające użytkowników, którzy niedawno się zalogowali. Niezgodność może spowodować powiązanie danych uwierzytelniających jednego konta z innym kontem.

Przedstawiciel OpenAI powiedział, że firma bada raport.