technologia

Praktyczne podejście Apple do sztucznej inteligencji: bez przechwałek, tylko funkcje

- W poniedziałek na WWDC Apple subtelnie reklamował, ile pracy firma wykonuje w zakresie najnowocześniejszej sztucznej inteligencji i uczenia maszynowego.

- W przeciwieństwie do większości firm technologicznych korzystających ze sztucznej inteligencji, Apple wykonuje zaawansowane przetwarzanie na swoich urządzeniach zamiast polegać na chmurze.

- Zamiast mówić o modelach i technologii AI, skupienie się Apple na produktach oznacza, że zwykle pokazuje tylko nowe funkcje, które są milcząco włączane przez sztuczną inteligencję za kulisami.

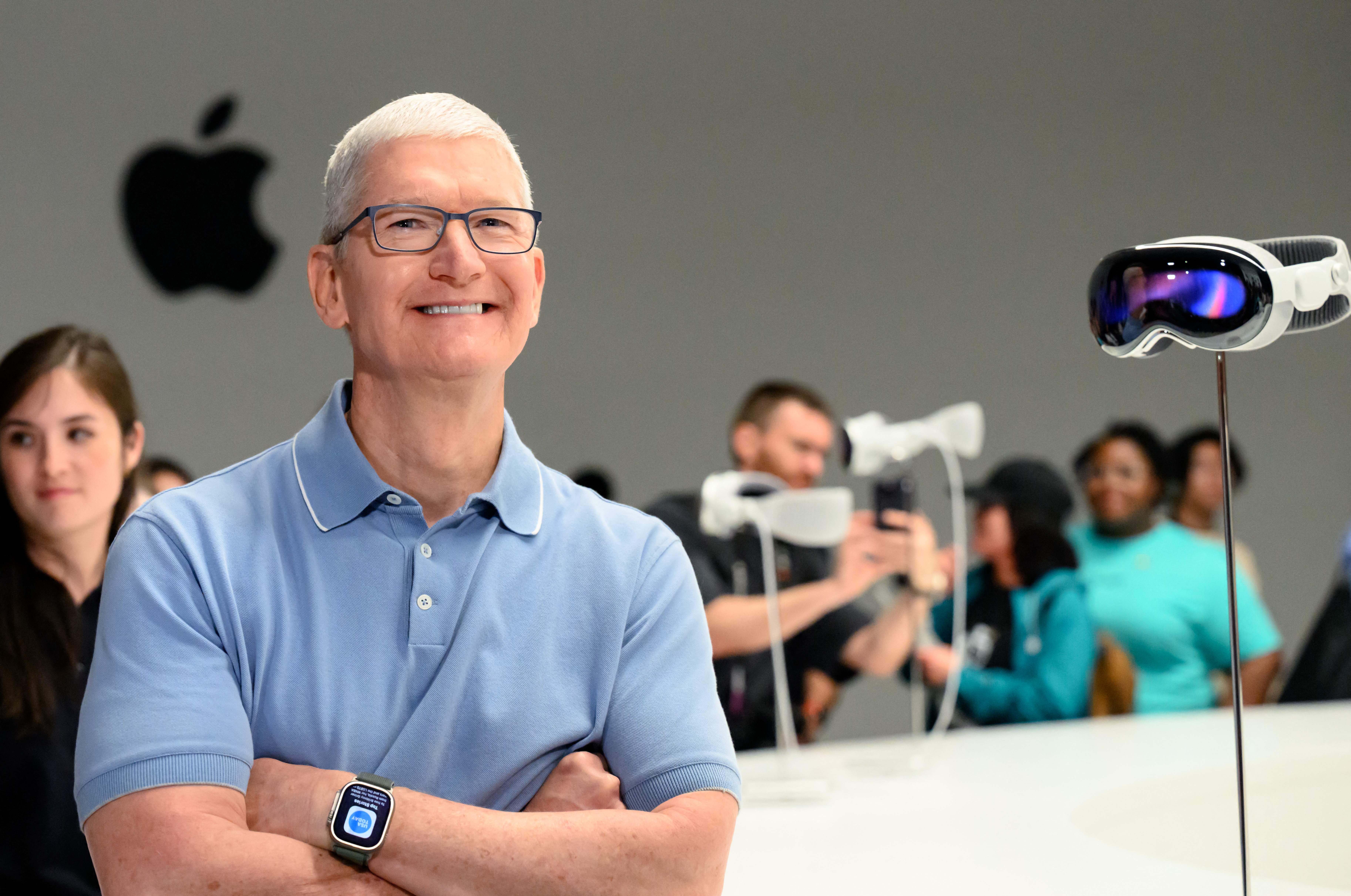

Apple Park jest widziany przed Worldwide Developer Conference (WWDC) 5 czerwca 2023 r. w Cupertino w Kalifornii.

Josh Edelson | AFP | Obrazy Getty’ego

W poniedziałek, podczas dorocznej konferencji programistów Apple WWDC, firma subtelnie reklamowała, ile pracy wykonuje w najnowocześniejszej sztucznej inteligencji i uczeniu maszynowym.

Gdy Microsoft, Google i startupy, takie jak OpenAI, wdrażały najnowocześniejsze technologie uczenia maszynowego, takie jak chatboty i generatywna sztuczna inteligencja, Apple wydawało się być na uboczu.

Ale w poniedziałek Apple ogłosiło kilka kluczowych funkcji AI, w tym ulepszoną autokorektę iPhone’a opartą na uczeniu maszynowym, która wykorzystuje model językowy Transformer, tę samą technologię, która leży u podstaw ChatGPT. Będzie nawet uczyć się na podstawie tego, jak użytkownik pisze i wpisuje teksty, aby stać się lepszym, powiedział Apple.

„Chwile, kiedy chcesz po prostu wpisać uchylone słowo, klawiatura też się tego uczy” – powiedział Craig Federighi, dyrektor ds. oprogramowania w Apple, żartując z tendencji autokorekty do używania bezsensownego słowa „uchylanie się”.

Największą wiadomością w poniedziałek był nowy, elegancki zestaw słuchawkowy Vision Pro z rozszerzoną rzeczywistością, ale Apple nadal pokazał, jak firma pracuje i zwraca uwagę na rozwój najnowocześniejszego uczenia maszynowego i sztucznej inteligencji. Podczas gdy ChatGPT OpenAI osiągnął ponad 100 milionów użytkowników w ciągu dwóch miesięcy, kiedy został uruchomiony w zeszłym roku, Apple wykorzystuje teraz tę technologię do ulepszenia funkcji, z której codziennie korzysta miliard właścicieli iPhone’ów.

W przeciwieństwie do swoich konkurentów, którzy budują większe modele z farmami serwerów, superkomputerami i terabajtami danych, Apple chce modeli AI na swoich urządzeniach. Nowa funkcja autokorekty jest szczególnie imponująca, ponieważ działa na iPhonie, podczas gdy modele takie jak ChatGPT wymagają setek drogich procesorów graficznych pracujących w tandemie.

Sztuczna inteligencja na urządzeniu umożliwia obejście wielu problemów związanych z prywatnością, z którymi boryka się sztuczna inteligencja oparta na chmurze. Jeśli model można uruchomić na telefonie, Apple będzie musiał zebrać mniej danych, aby go uruchomić.

Jest to również ściśle związane z kontrolą Apple nad stosem sprzętu, aż do własnych chipów krzemowych. Apple co roku umieszcza w swoich chipach nowe obwody sztucznej inteligencji i procesory graficzne, a jego kontrola nad ogólną architekturą pozwala mu dostosowywać się do zmian i nowych technik.

Apple nie lubi mówić o „sztucznej inteligencji” – woli bardziej akademicki termin „uczenie maszynowe” lub po prostu mówi o możliwościach, jakie umożliwia ta technologia.

Niektóre inne wiodące firmy AI mają kadrę kierowniczą ze środowiskiem akademickim. Doprowadziło to do skupienia się na pokazaniu swojej pracy, wyjaśnieniu, w jaki sposób można ją ulepszyć w przyszłości, oraz udokumentowaniu jej, aby inni mogli ją przestudiować i dalej rozwijać.

Apple jest firmą produktową i od dziesięcioleci utrzymuje ścisłą tajemnicę. Zamiast mówić o konkretnym modelu sztucznej inteligencji lub danych treningowych lub o tym, jak może to poprawić w przyszłości, Apple po prostu wspomina o tej funkcji i mówi, że za kulisami działa fajna technologia.

Przykładem tego w poniedziałek było ulepszenie AirPods Pro, które automatycznie wyłącza redukcję szumów, gdy użytkownik prowadzi rozmowę. Apple nie zaprojektował tego jako funkcji uczenia maszynowego, ale jest to trudny problem do rozwiązania, a rozwiązanie opiera się na modelach AI.

W jednej z najodważniejszych funkcji ogłoszonych w poniedziałek, nowa funkcja Digital Persona firmy Apple tworzy skan 3D twarzy i ciała użytkownika, a następnie może wirtualnie odtworzyć ich wygląd podczas używania zestawu słuchawkowego Vision Pro podczas wideokonferencji dla innych osób.

Apple wspomniało również o kilku innych nowych funkcjach, które wykorzystały możliwości sieci neuronowych firmy, takie jak możliwość identyfikacji pól do wypełnienia w pliku PDF.

Jednym z największych okrzyków popołudnia w Cupertino była funkcja uczenia maszynowego, która pozwala iPhone’owi zidentyfikować twojego zwierzaka — w porównaniu z innymi kotami lub psami — i umieścić wszystkie zdjęcia zwierząt domowych użytkownika w jednym folderze.

„Certyfikowany guru kulinarny. Internetowy maniak. Miłośnik bekonu. Miłośnik telewizji. Zapalony pisarz. Gracz.”